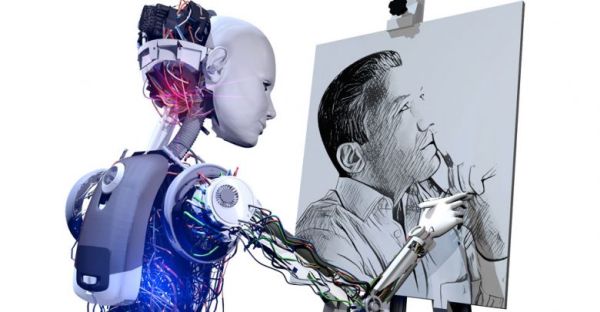

A számítógépes technológiák, különösen a mesterséges intelligencia jelentősen megváltoztatták az alkotás folyamatát: demokratizálták azt, illetve fontos szerepet játszva benne, minden korábbi segédeszköznél jóval hatékonyabban támogatják munkánkat. Számítógép és kreativitás viszonya azonban még magasabb szintű is lehet, mert a programok elvileg önálló alkotó entitássá válhatnak. Részben ez történik az olyan MI-alkalmazások esetében, mint a DALL-E-2, a Midjourney vagy a Stable Diffusion.

Csakhogy amikor a mesterséges intelligencia látványos fejlődéséről beszélünk, és teljesítményét összehasonlítjuk az emberrel, az elemzések rendszeresen megemlítenek néhány kivételt. Ezeken a területeken az MI egyelőre nagyon távol áll tőlünk, és hosszú időbe telhet, míg utoléri a Homo sapiens szintjét, ha valaha is utoléri egyáltalán. Egyikük a számítógépes/gépi vagy mesterséges kreativitás.

- A kreativitás persze többféle lehet: új értelmet adva nekik,

- reprodukál korábbi alkotásokat, szintén meglévő műveket kapcsol össze, valamilyen plusztartalommal gazdagítva azokat,

- illetve (a semmiből) teljesen új világot teremt.

Az MI egyelőre csak az első kettőben teljesít jól, és amikor MI-művészetről beszélünk, azokat értjük rajta.

A különféle tudományos diszciplínákat integráló szakterület, a számítógépes kreativitás a komputeres technológiák emberi alkotótevékenységet vizsgáló, modellező, utánzó és növelő alkalmazásaival foglalkozik. Kísérletezés innovatív képzőművészeti, irodalmi, zenei, építészeti, mérnöki, vagy éppen gasztronómiai ötletekkel, esetleg matematikai elméletek kitalálásával. Mesterséges intelligenciát használ komputerrel korábban kivitelezhetetlennek vélt munkák, például festmények, szobrok, irodalmi szövegek vagy zenedarabok létrehozására.

Az eredmények általában távol vannak az emberi szinttől, viszont a matematikai pontosságukról és logikájukról ismert szerkezetekről évtizedekkel ezelőtt senki nem gondolta, hogy az én- és öntudattal rendelkező lények privilégiumának tartott – valamilyen szintű – kreatív tevékenységre lesznek majd képesek. Ez a tény már önmagában, az alkotások művészi értékének minősítése nélkül is óriási előrelépés.

A terület gyorsan fejlődik, ugyanakkor több alapkérdést még mindig pontosan meg kellene válaszolni. Ezek egyike maga az objektív terminológiával nehezen vagy talán sehogy sem definiálható kreativitás: mi az – elmeállapot, tehetség/adottság vagy folyamat, ezek kombináció, vagy mind együtt? A nagybetűs alkotástól hétköznapi megnyilvánulásokig, az emberi tevékenységben is számos formája létezik, de ez a sokszínűség hogyan ültethető át a programok, gépek világába? Elképzelhető-e, hogy ne a rendszer tervezőjének, működtetőjének, hanem magának a rendszernek az alkotótevékenysége válik elsődlegessé? Hogyan, milyen kritériumok alapján mérhető egy gép kreativitása?

A kimagasló alkotótevékenység szintén problémát jelent. Mivel általában a szabályok megszegéséhez, felrúgásához, a megszokások semmibevételéhez társítjuk, hogyan érjük el, hogy a működésükben szabályokhoz kötött programok, algoritmusok, bizonyos mértékben önmagukon túllépve, kreatívak legyenek?

Egyre több számítástudományi szakember szerint. pozitív és negatív példák alapján a komputerek nemcsak arra képesek, amire programozták őket. Nagyon bonyolult rendszerek működését esetenként maguk a tervezők sem látják át, és ezek a rendszerek – nem csak hibák miatt – akár előre nem jelezhető kimeneteket, például egyre minőségibb műalkotásokat generálhatnak.

Marcus du Sautoy angol matematikus Turing-teszt helyett (Ada Byronról elnevezett) Lovelace-tesztet javasol, amin egy MI akkor megy át, „ha sikerül megismételhető módon létrehoznia valamilyen műalkotást, de a programozó nem talál rá magyarázatot, hogy hogyan csinálta. Ez a gép által teljesítendő próbatétel: előállni valami újjal, meglepővel és értékessel. Többet kell hozzáadnia a végeredményhez, mint amennyit a kódoló és a kezdeti

adatokat összeállító ember kreativitásából adódna.”

A kód tanul, mutálódik és fejlődik, a folyamat végére teljesen más lesz, mint amilyenre írták, fejlesztői által elképzelhetetlen outputokkal állhat elő. Egy irodalmi párhuzam: James Joyce szülei DNS-ét örökölte, kreativitása viszont a tanulás és a környezet, a világ észlelésének eredménye volt.

Nagy kérdés, hogy képesek lesznek-e valaha is nem meglévő alkotásokat létrehozni, kreatívan módosítani rajtuk, nem modellekből kiindulni, hanem helyette a semmiből új világot teremteni?

Frissítve: 2025. június 21.